AI向けGPU不足解消を待っていられないため?

Amazon、AWS向け新型チップ発表。AIモデルの訓練と実行に特化

空前の生成AIブームのなか、学習・実行に必須となるGPU不足が深刻化している。NVIDIAの最高性能チップは2024年まで完売しているといわれ、チップ製造を請け負うTSMCもAIチップ不足が2024年末まで続くと示唆していた。

そんななかAmazon Web Services(AWS)は29日、年次カンファレンス「re:Invent」にて、大規模言語モデル(LLM)の訓練と実行に特化した最新世代チップ「Trainium2」とクラウド向けプロセッサー「Graviton4」を発表した。

まずTrainium2は、2020年12月に発表された第1世代Trainiumと比べてパフォーマンスが最大4倍、電力効率が2倍向上しているとのこと。このチップはクラウドコンピューティングサービス「Trn2」インスタンスで利用でき、「EC2 UltraCluster」では最大10万チップまで拡張できるとのこと。

10万個のTrainiumチップは、65エクサFlopsの演算能力を提供できるという。エクサFLOPSとは浮動小数点演算を毎秒100京回行える性能であり、ゲーム機の性能によく使われるTFLOPSとは毎秒1兆回処理できる性能のことだ。

そして10万個のTrainiumチップクラスターは、3,000億パラメーターのLLMを数週間~数か月で訓練できるという。パラメーターは、LLMを構成するニューラルネットワークの状態を意味する。

人の脳では神経細胞(ニューロン)を結合するシナプスは100兆個以上もあるため、一般的にパラメーターもこれに近づくことを目指している。そして3000億パラメーターは、GPT-4の前身であるGPT-3の約1.75倍のサイズである。

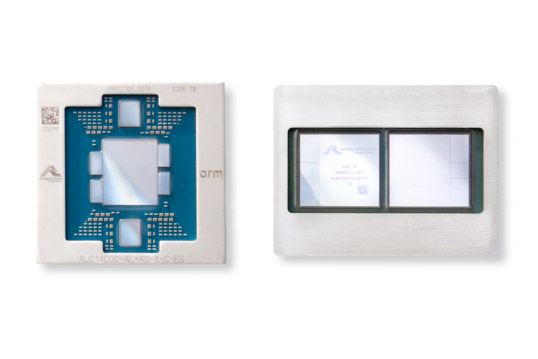

もう1つの新型チップ「Graviton4」はArmベースであり、推論を目的としている。公式発表によれば、前世代のGraviton3よりも演算能力が最大30%向上、コア数は50%増え、メモリ帯域幅は75%増とのことだ。

こちらは「これまで開発した幅広いワークロード向けの中で最も強力でエネルギー効率の高いチップ」と説明されている。Graviton4は、Amazon EC2 R8gインスタンスで利用可能になる。

おりしも今月中旬、マイクロソフトも独自開発AIチップ「Maia 100」「Cobalt 100」を発表したばかりだ。今後1~2年は、生成AIの分野ではドッグイヤーどころではない速さで技術革新が進みかねないため、ハイテク各社はこぞって独自開発のAIチップを用意することになりそうだ。

- Source: Amazon

- via: TechCrunch