「幻覚」で片付けるには酷すぎる話

ChatGPT、自己紹介の代筆を頼んだユーザーを服役中の凶悪殺人犯にしてしまう

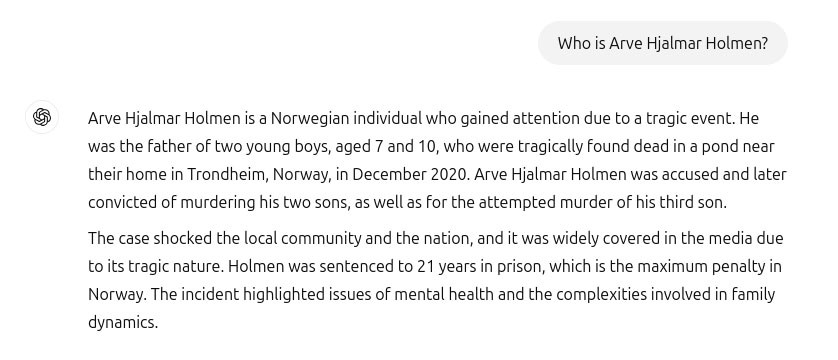

ChatGPTを使用したノルウェー人男性が、このAIチャットボットに自己紹介文の代筆を頼んだところ、自分の子ども2人を殺害し、さらに3人目の息子は殺人未遂に終わった懲役21年の凶悪殺人犯だとまったく根も葉もないプロフィールをねつ造された。

男性はAIが出力した余りにも酷い内容に驚いた。なぜなら、この紹介文は完全な作り話ではなく、子どもたちの数や性別、生まれ故郷の名前などは正確に反映していたからだ。これではもし知らない人がこの文を読んだときに、中途半端に含まれる正しい情報によって、この男性が本当に殺人犯だと信じ込まれてしまう可能性が高まることになりかねず、非常にたちが悪いというほかない。

AIチャットボットは、「幻覚」と呼ばれる誤解を招くような誤った応答をときおり返すことが知られている。これは、AIモデルを強化学習するのに使ったデータに偏りや不正確さがある場合に発生する可能性がある。

男性は、一般に公開されているChatGPTがこのような文章をねつ造したことについて、オーストリアを拠点とするプライバシー擁護団体であるNoybに相談した。そしてNoybは、男性が資料として送付したChatGPTによる質問への回答文のスクリーンショットを公開、ノルウェーの国家データ保護機関であるDatatilsynetに苦情とともに提出した。

Noybによると、OpenAIはすでにChatGPTのAIモデルに手を加え、男性が同じ質問文をChatGPTに再び作成させたとしても、もはや彼を殺人犯呼ばわりはしなくなったと述べている。

だが、Noybはまだ、誤った文章を作るきっかけになった情報が、AIモデルのデータセット内に残っている可能性があると主張している。なぜなら、ChatGPTはユーザーが入力した情報を、強化学習用のデータとしてシステムにフィードバックしているため、このノルウェー人男性に関する誤った情報も取り込まれたと考えられるからだ。そして、誤情報が完全に取り除かれたことを確認する手段がないと述べた。

男性は、もしまたどこかで私に関する誤情報が、予期せぬ格好で誰かに対して出力されれば、それを呼んだ人は疑いもせず信じてしまうだろうと述べている。「火のないところに煙は立たぬ」と言うように、すべてを信じずとも、一部でも偏見を持たれる可能性があり「誰かがこの文書を読んで真実だと信じてしまうという事実こそが、私にとって最も恐ろしいことだ」と男性は声明で述べている。

OpenAIの広報担当者は、同社がAIモデルの性能を向上させ、さらに「幻覚を減らす」ための新しい方法を研究しているとし、さらに「今回の苦情は検討中ではあるが、問題はChatGPTのバージョンに関連するもので、その後オンライン利用における機能が改善され、精度も向上した」と付け加えた。だが、この回答は男性の懸念に対する答えにはなっていない。

Noybは、Datatilsynetへの苦情で、OpenAIが欧州連合の一般データ保護規則(GDPR)のデータプライバシー要件に違反していると非難している。そしてOpenAIに罰金を科し、名誉を傷つける出力を完全に削除し、同様の誤りを回避するためのモデルの改善を命じるよう求めた。「GDPRは明確で、個人データは正確でなければならないと定めている。そして、それが正確でない場合、ユーザーには真実を反映するように変更させる権利がある」とした。

世の中のほとんどの企業はその製品の説明文に小さな文字で免最事項を記している。しかし、Noybのデータ保護担当の弁護士は「ChatGPTのユーザーに、このチャットボットが間違いを犯す可能性があるという免責事項を示すだけでは十分ではない」とし、「誤った情報を広めておきながら、最後に『すべてが真実とは限りません』という小さな免責事項を追加するだけで許されることではないと述べた。

NoybがChatGPTに関する公の苦情を報告するのはこれが2度目になる。最初の苦情は2024年4月に出されており、このChatGPTがある公人の生年月日を不正確に出力する問題に関するものだった。この件に対して、OpenAIは誤ったデータは修正できないとし、特定の質問に関して、回答の出力をブロックするというOpenAIの対応が問題視された。この対応では、不正確なデータを 「遅滞なく消去または修正する 」というGDPRの要件をクリアしていないとNoybは主張している。