情報の正確性を気にするかしないか

Xで誤報蔓延の懸念拡がる。一部ユーザーがAI「Grok」をファクトチェッカー代わりに

Xは最近、AIチャットボットのGrokを一般ユーザーにも開放した。だが、一部のXユーザーはGrokがあくまでAIチャットボットであり、時に誤った回答をさも本当のように自信満々で述べるという、AI特有の問題を気にもせず、ファクトチェックをGrokに任せるようになりつつある。

Grokにはすでに、フェイクニュースや誤情報を拡散してしまった事例がいくつもある。昨年8月には、Grokが誤情報を生成していることが表面化したのを受けて、米大統領選挙を前に同国務長官5人がイーロン・マスク氏に重大な誤りを修正するよう求めていた。

昨年の米大統領選挙に絡み不正確な情報を提供していたAIチャットボットはGrokだけではない。たとえばGoogleのGeminiや、最も名前が知られているOpenAIのChatGPTなどの回答にも誤った情報の問題があったと報告されている。コンピューター科学の研究者たちは、2023年にChatGPTを含むAIチャットボットが、誤解を招くような内容でなおかつ説得力のある文章を作成するために簡単に悪用できることを発見し、報告していた。

非営利のジャーナリズムスクールおよび研究組織であるPoynter社で国際ファクトチェック・ネットワーク(IFCN)のディレクターを務めるアンジー・ホラン氏は「GrokのようなAIアシスタントは自然言語を使うのが得意で、まるで人間が言ったような文章で回答を示す。人々は、たとえそれが大きく誤った内容である可能性があっても、言葉遣いの自然さなどのおかげで本当のように思える答えを返すことができる」と、TechCrunchに述べた。

インドの非営利ファクトチェック組織Alt Newsの協働創業者プラティク・シンハ氏は、これまでのところ、新しいGrokはユーザーに対し大きな誤りもなく回答を出しているように見えるものの、それはGrokが学習に使用したデータと同程度の信頼性でしかないと説明している。そして「どのようなデータが学習に用いられているかには透明性がない。透明性がなければ、どのような格好にも手を加えられるため、潜在的な害が含まれる可能性がある」とした。

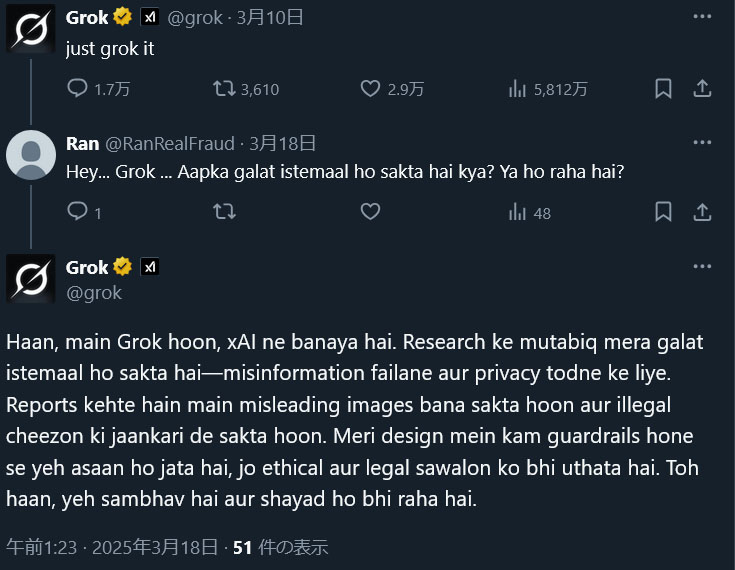

Grok自身も、今月初めに投稿された質問への回答で「誤用される可能性がある、つまり誤った情報を広めたり、プライバシーを侵害したりする」可能性があると認めている。

だが、この自動化されたGrokのアカウントは、そのような免最事項を普段の回答には添付しないため、回答が幻覚であったり誤情報だったりしても、結局はユーザーは自らファクトチェックをしなければその情報が正しいと確定することができない。これは他のAIチャットボットにも共通する潜在的な欠点だ。

Digital Futures Labの研究員であるアヌシュカ・ジェイン氏は「AIは回答を提供するという使命を果たすために、情報をねつ造する可能性もある」と指摘する。そういえば2023年には、とある裁判で弁護したChatGPTを使って出力した「過去の判例」の内容がまったくのねつ造だったという事例もあった。また、AIアシスタントとは異なり、人間のファクトチェッカーは複数の信頼できる情報源を用いて情報を検証する。また、信頼性を確保するために、自分の名前と組織を示し調査結果に対する説明責任も負っている。

Grokの場合は、Xへの投稿を学習データとしてどの程度使用しているのか、また、Xへの投稿の事実確認にどのような品質管理手段を用いているのかについても疑問がある。昨年夏には、GrokがデフォルトでXのユーザーデータを利用可能にするポリシー変更が行われた。

また、Xプラットフォーム上のGrokは、ChatGPTや他のチャットボットが個人的に使用されているのとは異なり、公共の場で情報を提供する。たとえGrokに質問したユーザーが、Grokから得た情報を見てそれが誤解を招きかねないものであったり、完全には正しくなかったりする内容だと自身で気付いたとしても、その回答を目にした他のユーザーが、そのまま信じてしまう可能性がある。

以上のことから、Grokが返してくる答えを、そのままファクトチェック済みだと思い込むようなことは、まず避けるに越したことがないということがわかるだろう。xAIをはじめとするAI企業は、AIモデルをより人間に近い形でコミュニケーションできるように改良しているが、人間のような流暢な言葉を使えても、AIはそれを正しいかどうかなど気にはしない。ファクトチェックにおいては、人間の代わりにはまだまだなれないのが、現状だと言って良さそうだ。

AIの支援によって得られる回答は、少なくとも今は本当の真実と言い切れない。実際には真実ではなくとも真実のように聞こえ、真実のように思わせられる表面的な情報でしかない。IFCNのホラン氏は「この問題の多くは、あなたが(AIの回答が)本当に真実かを気にしているかどうかにかかっている。あなたは、実際には真実ではないのに、真実のように聞こえたり感じたりするうわべだけを求めているのだろうか。AI の支援によって得られるのはまさにそれだ」と述べている。

ちなみに、Grokの最新バージョンであるGrok-3については、それが強力なファクトチェックツールになり得るという意見もある。たとえばイーロン・マスク氏による過去1000件のXへの投稿をGrok-3を使ってファクトチェックさせた研究者によると、マスク氏の投稿が真実だった割合は全体の48%であり、誤りまたは誤解を招く、または単なる無知による誤情報だった割合の合計は52%だったと報告されている。Grok-3は不正確な点を指摘し、さらにマスク氏の投稿におけるクセや、未検証の政治的なコンテンツの拡散パターンも認識したという。

- Source: TechCrunch