Appleシリコンに対する逆襲

インテル、オープンソースのNPU高速化ライブラリを公開。最新ノートPC上で軽量LLMが動作

インテルはついに、オープンソースのNPU(Neural Processing Unit)アクセラレーション・ライブラリを公開した。これにより、開発者らはアプリを同社のAIエンジンに最適化でき、ローカルPC上でLLM(大規模言語モデル)を動かしやすくなった。

この一報は、インテルの技術エバンジェリスト(自社製品の特徴などを分かりやすく説明し、普及させる役職)、トニー・モンコルスマイ氏がXで述べたことだ。これにより、MSI Prestige 16 AI Evo(インテルCore Ultraプロセッサー搭載ノートPC)上で、TinyLlamaとGemma-2b-itといった軽量LLMが動かせたと付け加えている。

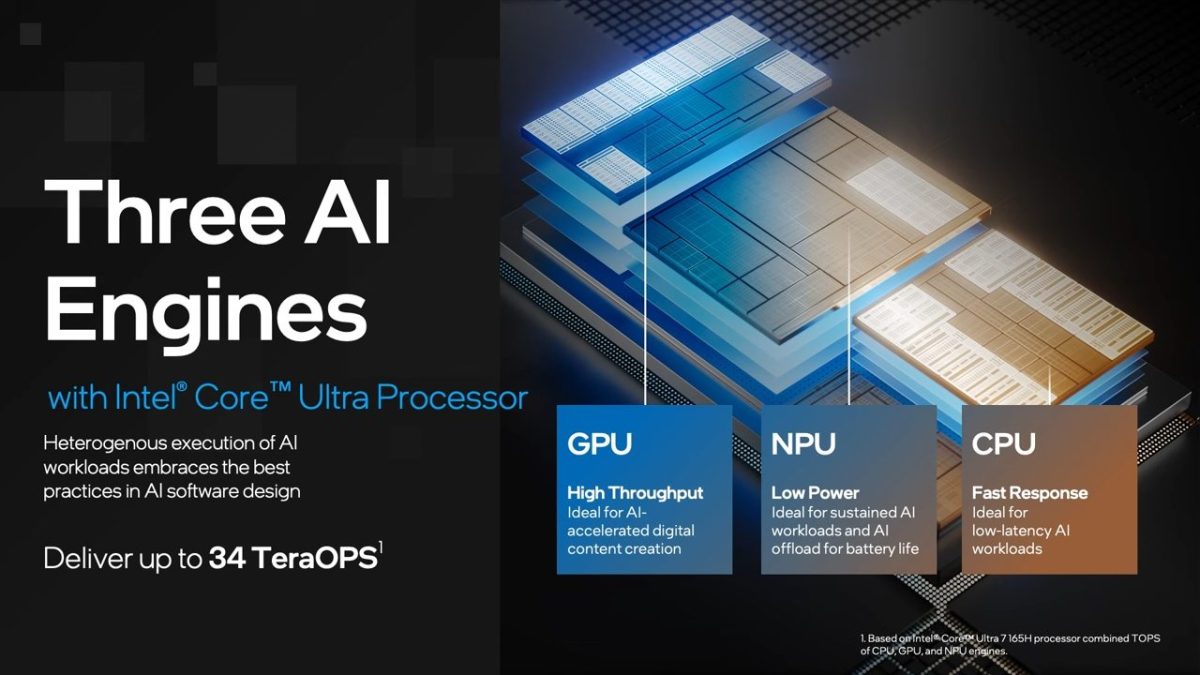

インテルは昨年末に新世代の「Core Ultra」プロセッサーを発表したが、ここ最近ノートPCベンダー各社が採用した新製品を相次いで投入し始めている。特に重きが置かれているのが、AI処理に特化した統合NPU「AI Boost」だ。AI推論処理をCPUやGPUより高い電力効率で実行でき、AIアプリをローカル側で処理し、クラウドへの依存を減らす鍵になる。

どれだけ素晴らしいポテンシャルを秘めていても、利用できる人が限られていれば宝の持ち腐れにもなりかねない。インテルがCore Ultraプロセッサーの普及を望むのであれば、一部の関係者がNPU関連ライブラリーを独占するよりも、広く門戸を開いた方が得策という戦略なのかもしれない。

たとえばM1やM2といったAppleシリコン(アップル独自設計プロセッサー)は、アップルが仕様やライブラリーをオープンにしなかったことで、Linux移植プロジェクトも当初は大苦戦していた。数年にわたってインテル製チップはAppleシリコンに対して精彩を欠いた時期もあったため、AIブームに乗った巻き返しを図っているのだろう。

とはいえ、本ライブラリーは「開発者がNPU用のモデルで作業するためのもの」とされ、一般ユーザーが今すぐに生産性を上げられるわけではない。また完全にNPU向けに書かれているため、Core Ultraより以前のNPU非搭載プロセッサーで使うことは不可能である。

モンコルスマイ氏はPythonコードのスクリーンショットを公開しているので、腕に覚えがある方は参考にして自らコードを書くか、ないしは同氏のコードを書き写して試してみるのもいいだろう。

- Source: Tony Mongkolsmai(X)

- via: Wccftech