ソニーのaiboが「おてつだい」に挑戦。3D空間の認識精度を高める技術を万博で披露

ソニーの「aibo(アイボ)」は愛らしい仕草でオーナーを和ませてくれる、愛犬タイプのエンターテインメントロボットだ。

このほどソニーグループは、aiboに家の間取りや家具の位置を3次元的に覚えさせて、家族のために “お手伝い” をしたり、新たなかわいいモーションを追加する実験を行った。筆者は8月24日まで大阪・関西万博会場で公開された、aiboの試作機による展示を取材した。

大阪・関西万博にaiboが登場

ソニーは2018年1月11日から、ソニー独自のAIや通信機能を搭載するaibo(ERS‑1000モデル)を販売している。発売後もオンラインサービスを通じて新しい機能を追加したり、操作性やセキュリティーを改善するためのソフトウェアアップデートを定期的に実施してきた。

今回筆者は、ソニーが現在試作する技術の用途提案を目的として、初めて一般に公開されたaiboの新しい機能を取材した。先にお伝えしておくと、現在開発中の技術は将来ソニーがaiboに載せることを想定しながら開発しているものではあるが、その時期や提供方法は現在のところ未定とされている。

また、aiboの展示は「ロボット&モビリティステーション」館に、2025年8月18日から24日まで期間を限定して出展した愛知県のブースで見せていたものだ。本稿掲載時には残念ながら展示が終了していることもお断りしておきたい。なお、ソニーが愛知県の出展に参加した背景には、aiboが愛知県幸田町の工場で製造・修理を行っているからだという。

複数のセンサーで3D空間を正確に認識

デモンストレーションの内容と、ソニーがいま試作している新しい機能については、ソニーグループでaiboの開発を担当するソフトウェアエンジニアの宇佐美 真之介氏に詳しく聞いた。

今ソニーが挑んでいる新しい技術は、aiboの立体空間の認識力を高めることと、認識した空間情報を例えば3Dマップのような形でビジュアル情報として出力することだ。

現在ソニーが発売中のaiboは、頭部と胴体にそれぞれ1台ずつ上向きに配置するカメラを載せて、複数種類のセンサーから集まる情報を掛け合わせながらリアルタイムに室内の環境地図をつくり、自己位置を推定するV-SLAM(Visual Simultaneous Localization and Mapping)に近い技術を使って移動している。

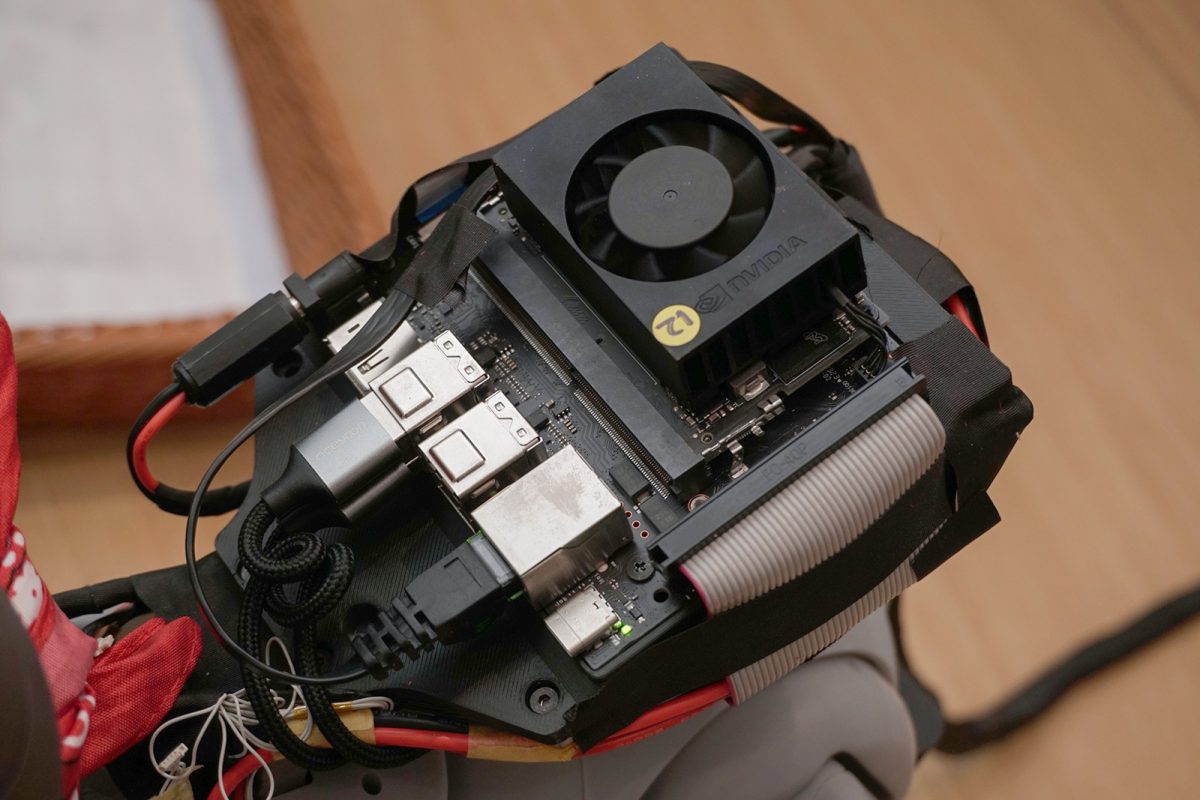

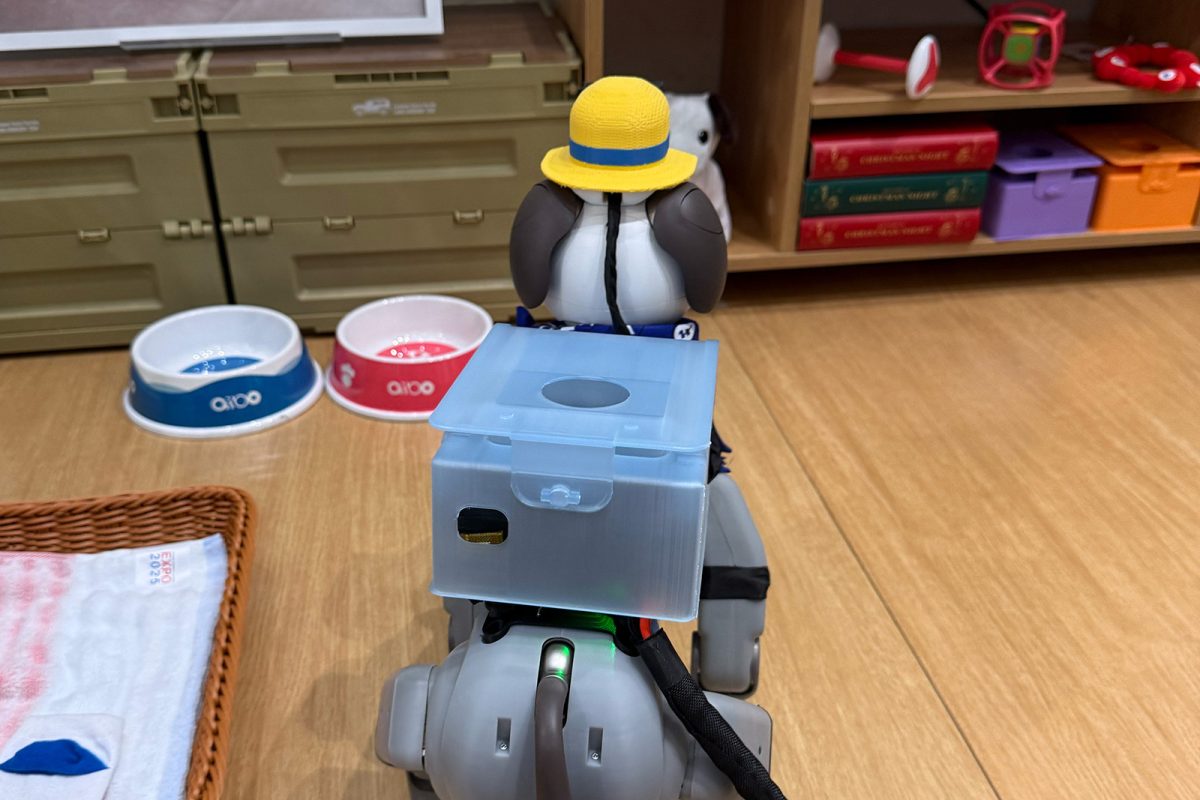

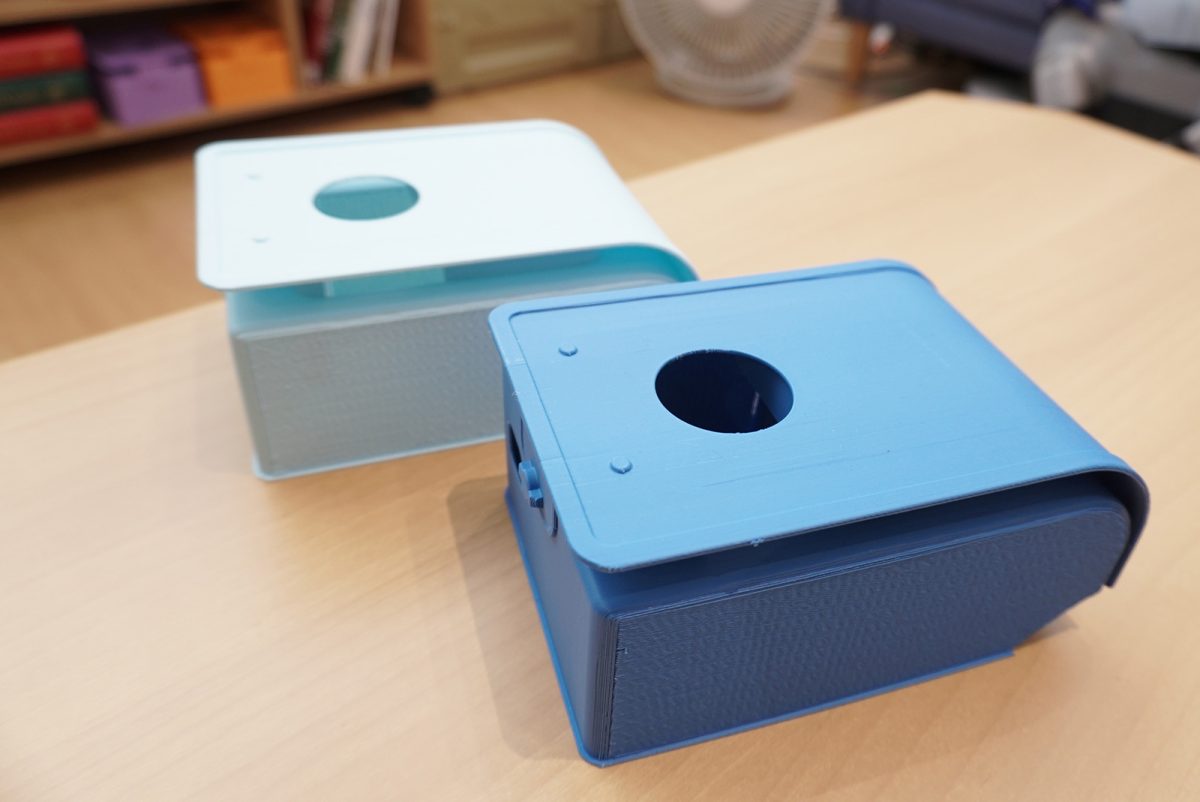

今回ソニーが展示したaiboの試作機は、環境の立体情報をさらに高精度に認識する技術を高めたと宇佐美氏は説明する。革新の鍵はaiboが頭に載せている「帽子」のようなユニットに内蔵するセンサー群と新しいソフトウェアにある。試作機はそれぞれを動かすためのMCU(マイクロコントローラー・ユニット)を背中に乗せた “ランドセル” や “マント” に仕込んでいる。

頭部のユニットには、人間の目と同じように物体の色や形など視覚情報を認識するRGBカメラがある。このほかに、iToF(indirect Time-of-Flight)方式の距離画像センサーにより、目の前のオブジェクトに赤外線を照射し、対象物から反射して戻ってくるまでの時間差を計測することで、物体までの正確な距離(奥行き情報)を導き出す。

ユニットの中にはIMU(慣性計測ユニット)もある。加速度と角速度を計測しながら、aiboの姿勢や動きの変化をリアルタイムに捉えて位置推定の補正を行う。このIMUがあることにより、RGBカメラからの視覚情報だけに頼らずに、多少見晴らしが悪い場所でも安定した動作が可能になるという。

おてつだいをしたり、涼んだり。aiboの新たな挑戦

これらのセンサーから得られたデータを融合しながら、複数の処理を行うことで物体の立体的な認識を行う。

aiboはクラウドベースの正確な絶対位置推定(Accurate Absolute Localization:VPS)と、iToFセンサーなどを使う高速な相対位置推定(Fast Relative Localization:VIO)により、家の中でも正確に自己位置を推定する。

ソニー独自のAIモデルは、ToFセンサーから取得する奥行き情報と、カメラの画像情報を融合させることで詳細な3Dマップを作成する深度融合(Depth Fusion)や、周囲にある壁・床・家具などをセグメンテーション(領域分割)しながら認識するパノラミックセグメンテーションなどの技術に活用される。

aiboがリアルタイムに作成する3Dマップは「無数の点が集まる点群情報」として表現される。今回のデモンストレーションでは、aiboがどのように室内空間にあるオブジェクトと「歩行可能なエリア」を認識しているのか、視覚化するアプリケーションの画面をモニターに映しながらわかりやすく見せていた。

万博会場で行われていた2種類のデモンストレーションを動画で撮影した。それぞれの様子見ていただければ、aiboが「できること」がよくわかると思う。

ひとつはaiboがくつ下を加えて「洗濯かご」まで運ぶデモンストレーションだ。

もうひとつはaiboが扇風機の前に座って「涼む」かわいらしいデモンストレーションだ。

どちらもaiboが「扇風機」や「洗濯かご」の情報をセンサーフュージョンの技術により認識・分類しながら、最適な動作をスムーズに実現している。扇風機や洗濯かごは、事前に様々な家具や小物の写真と、それぞれを色んな角度から描いた3D画像モデルをソニー独自のAIモデルに学習させたデータを元にaiboが認識・分類しているという。「aiboの低い視点から見たオブジェクトのデータを用意することが重要」なのだと宇佐美氏は説く。加えて「洗濯かごにくつ下を運ぶ」「扇風機の前で涼む」という行動を、宇佐美氏の開発チームがaiboに覚え込ませた。同様の手順を踏むことで、aiboに様々なお手伝いをしてもらったり、空間と物体の関係性を覚え込ませて、新しい仕草(モーション)を追加することも可能になる。

「例えば将来、aiboにわが家のソファや家具のサイズを測ってもらうこともできます。さらにセンシングの能力を高めれば、お留守番中、ソファに座っているおばあちゃんの様子を見守ってくれるエージェントのような役割もaiboが担えます」(宇佐美氏)

これから実装手段を検討する段階

周囲の環境が立体的に把握できるようになれば、aiboが机の下をくぐったり、ソファによじ登って高い場所にあるものを見るといった動作も可能になるという。その際にはある程度高い場所にジャンプして登ったり、aiboの運動能力を高める必要もありそうだ。

宇佐美氏は今後も「目印となる家具などが少ない、がらんとした空間での自己位置推定や、動いている人や物に依存せずに安定して自己位置を推定する精度を高めることを、引き続き課題として取り組みたい」と語った。

万博での出展はわずか1週間という短い期間だったものの、aiboのかわいらしい仕草に惹かれて、子どもたちをはじめ多くの来場者がブースを訪れたという。

「aiboが家庭内の3D空間を正確に理解する」という少し難しい主題の展示だったが、「aiboが“くつ下を洗濯かごに入れる”という、誰もがひと目見てわかるデモンストレーションを用意したことで、aiboがお手伝いを通じて人間との関係性をより深めていくイメージが伝えられたのではないか」と、宇佐美氏はよい手応えを感じている様子だった。筆者もaiboと暮らす生活がより楽しくなる未来を想像できた。

ソニーは今回展示で見せた技術を近く実現するために、これからも引き続き開発を進めていくという。宇佐美氏に聞くと、現在販売するaiboのソフトウェアをアップデートするだけで同じ機能が実装できるのか、またはaiboに「専用アクセサリー」のような形で必要なハードウェアを追加したり、まったく別の新しいaiboを開発する方がベターなのか等、技術的な検証とともにコストバランスの検討を経た後に、また次の具体的なステップが見えてきそうだ。これからの展開にも注目したいと思う。

万博で出会えるソニーグループの技術

aiboの新技術のデモンストレーションは8月24日に終了してしまったが、ほかにも大阪・関西万博でソニーの先端技術に触れられる展示がある。

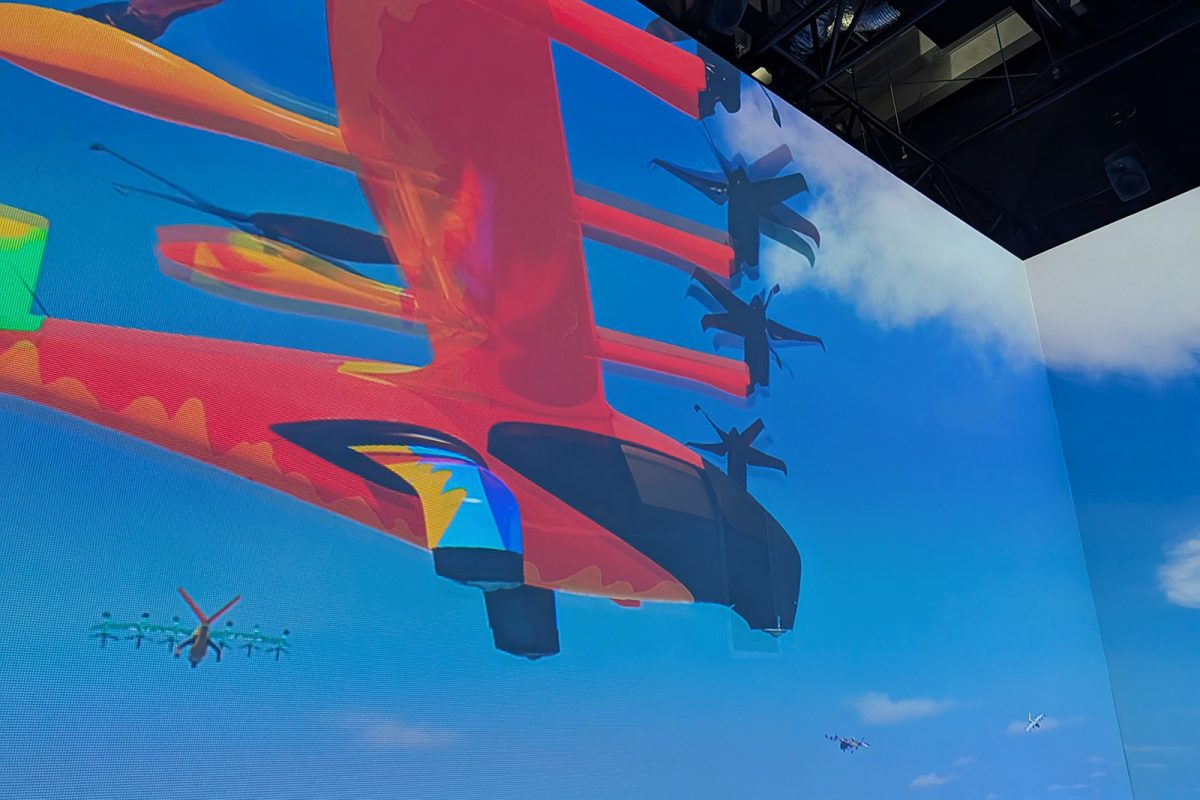

展示施設「空飛ぶクルマ ステーション」では、JALグループが将来の社会実装を目指すeVTOL(電動垂直離着陸機)の運航イメージが体験できるイマーシブシアター「SoraCruise by Japan Airlines」を公開している。ソニーの立体音響技術による空を飛んでいるような生々しいサウンドと、シアターの床に埋め込まれたハプティクスセンサーの振動が圧倒的な没入感を再現する。

前面・左右側面と床面の大型スクリーンに広がる映像にのめり込んだ瞬間、高所恐怖症の筆者は思わず脚がすくんでしまった。約15分間のシアター体験はソニーPCLが企画・制作している。こちらの展示は事前予約が必要になるので、万博に脚を運ぶ前にウェブサイトを確認したい。

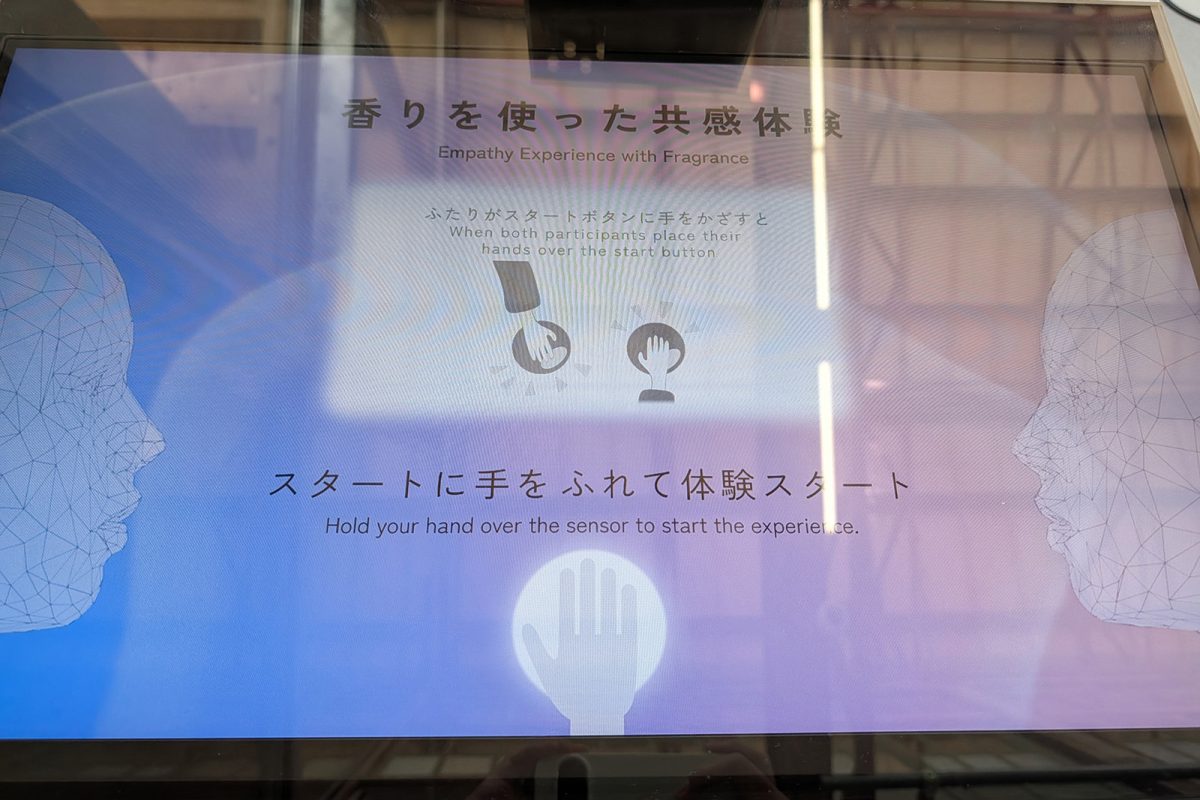

ほかにも万博会場「シグネチャーゾーン」の「Dialogue Theaterーいのちのあかしー」には、資生堂とソニーのにおい制御技術Tensor Valveテクノロジーのコラボレーションによる「香りを使った共感体験」の体験型コンセプト展示がある。

西ゲートゾーンの「ガスパビリオン おばけワンダーランド」では、「XR Channel」アプリを立ち上げてスマホのカメラをホールに向けてかざすと“おばけ”と出会えるARイベントが楽しめる。入場を待つ時間も楽しく過ごせるのでぜひ忘れずに活用してほしい。