現時点での音声入力は英語のみ

Googleレンズ、動画での検索や音声での質問に対応。カスタム版Geminiを活用

Googleは、画像認識技術を用いた検索機能「Googleレンズ」で、動画での検索や音声による質問が可能となったことを発表した。

すでにAndroidとiOS版アプリにて、Search Labsに登録して「AIによる概要」を有効にしたユーザーを対象に展開している。これらは5月の開発者会議Google I/Oにて発表したもので、数か月越しに予告が実現した格好だ。

GoogleレンズはスマートフォンやPCのカメラが捉えた画像や、保存した画像を解析し、様々な情報を引き出せるものだ。Android端末では検索バーの右端にあるカメラのアイコンをタップすれば起動し、iOSにも専用アプリが配信中である。

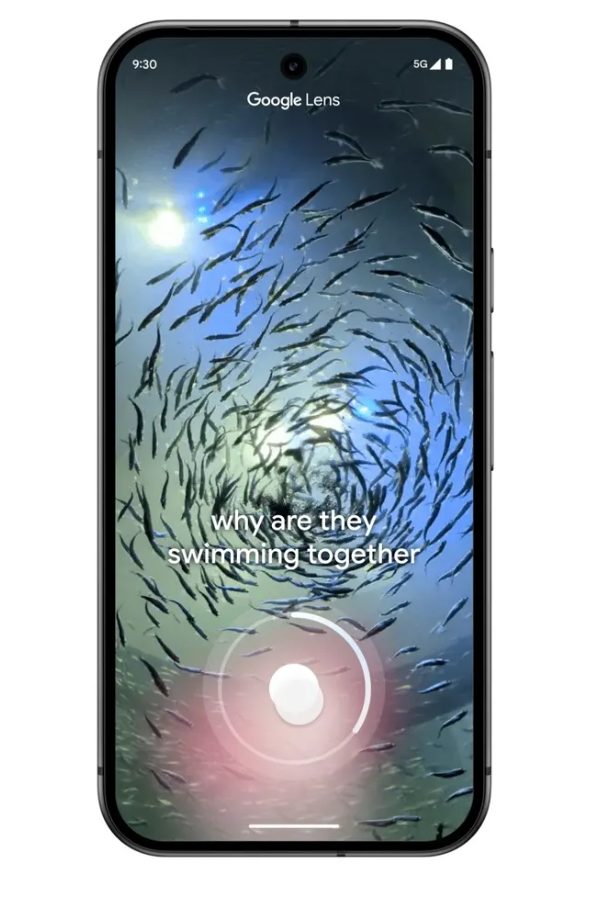

これまで検索対象は静止画のみだったが、新たに動いているオブジェクトを撮影して質問できるようになった。また、従来は追加の質問はテキストに限られていたのが、音声での質問も可能になる。

Googleによれば、水族館でスマホを魚たちにかざし、シャッターボタンを押し続けて録画を始め「なぜ彼らは一緒に泳いでいるのか?」と大声で質問できるという。GoogleのAIは動画と質問を一緒に理解して、AIの概要と検索結果を表示する。

ただし、録画は最大20秒まで。音声での質問は、英語だけに限られている。

これら機能を支える技術につき、以前Googleのエンジニアリング担当副社長Rajan Patel氏はThe Vergeに対して、動画を「一連の画像フレームとして取得し、その後、以前レンズで使っていたのと同じコンピュータビジョン技術を用いている」と語っていた。

が、現在では一歩進んで、情報をカスタム版のGeminiモデルに処理させているという。このモデルは「複数のフレームを順番に理解し、ウェブに基づいた応答を提供する」ために開発されたとのことだ。つまり1枚ずつ個別の処理ではなく、相互に関連付けて解釈しているということだろう。

まだ動画内の音を識別する機能はサポートされていない。たとえば、鳥のさえずりから名前を特定することはできない。Patel氏は「実験中」だと述べており、近い将来に実装される可能性がありそうだ。

- Source: Google

- via: 9to5Google The Verge