ビデオ会議中は会議に集中しよう

“目の映り込み”から風景を3Dレンダリングする技術が開発される

視覚は、角膜、瞳孔、水晶体という透明な組織を通して目に入る光に依存している。光が網膜に到達すると、受容体がそれを脳が理解可能な信号に変換し、神経を介して脳に伝達され、そこで画像として認識される。一方、眼球に入った光の一部は、角膜を覆っている反射率の高い液体の薄膜で反射され、目の中から外界に出る。

メリーランド大学の研究者たちは、この反射光から、その人が見ている風景を3Dモデルとして再構築する技術を開発した。

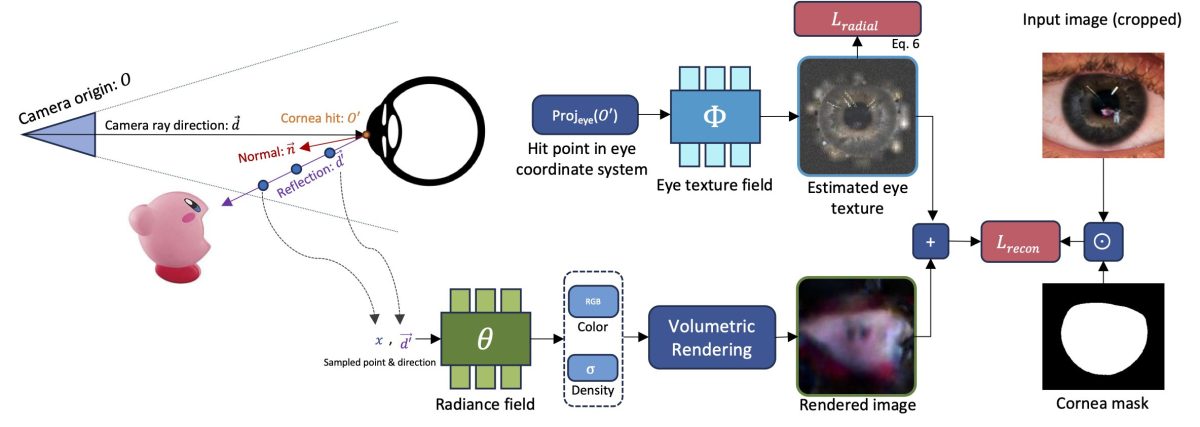

未査読論文を掲載するarXivに「Seeing the World through Your Eyes」として報告されたこの論文によると、複数の2D画像から3Dシーンを生成するAIニューラルネットワーク「NeRF」を用いて研究を実施。目の反射光をとらえて3Dモデルとしてレンダリングを行うというものだ。

研究では、まず高解像度カメラを固定し、証明写真を撮影する要領で人物の顔写真を複数枚撮影、その写真の目に映るものを拡大して、その人の視野の鏡像を取得した。また人によって異なる虹彩の模様を取り除き、その部分の胸像を得るためにもAI技術を活用して、より詳細な視界の像を得るようにした。

さらに、人の視線を正確に追跡するアルゴリズムを用いてカメラ角度を決定し、3Dレンダリングを行う際の視線方向の算出も行った。こうして取得された目に映る世界の画像は、解像度はあまり高くはないものの、深度マッピング情報を含んだものとして取得できた。

研究者らは、この装置がどれぐらい有効かを試すために、高品質なクローズアップと有利な照明状況が得られているサンプル映像として、マイリー・サイラスとレディ・ガガのミュージックビデオをピックアップした。そしてビデオ内のクローズアップのカットから目の反射にズームインして、撮影時にアーティストらが見ていたものを再構築してみようと考えた。

結果としては、マイリー・サイラスの場合は正面に配置されたLEDグリッドライトを見ていた可能性が高いことがわかったが、詳細はわからない。また、レディ・ガガの目には、三脚に取り付けられたカメラと人の胴体のようなものが見えたが、期待した解像度は得られず、やはり詳細は不明だった。

研究者らは、ミュージックビデオの場合はアーティストにすべての照明が向けられ、逆にアーティストが見ている方向は暗くなっている可能性が高いせいで、目に映るものも不鮮明になった可能性があるとしている。一方で、周囲も明るい自撮り撮影やビデオ会議の画像などでは、もっと被写体が見ているものがわかるようになる可能性がある。この技術が大きく進歩すれば、たとえばZoomミーティングの最中に横目でYouTubeを見ていたりすると、上司にそれが簡単にバレるといったことも起こるのかもしれない。

余談だが、この技術は人がそのときに見ているものの反射を画像として取得しているため、たとえばミステリー・ホラー小説などであるような、殺害された人物の網膜に焼き付いた殺害現場の状況を再現するといったことはもちろんできない。

- Source: arXiv(PDF) Seeing the World through Your Eyes

- via: New Atlas